Comment installer et configurer l'extension ?

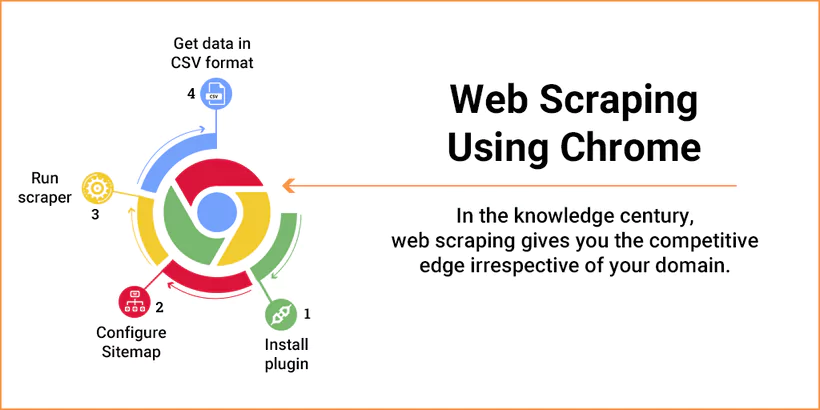

Installation (exemple : Web Scraper sur Chrome)

- Ouvrez le Chrome Web Store (chrome.google.com/webstore).

- Recherchez « Web Scraper » et cliquez sur « Ajouter à Chrome ».

- Confirmez l’installation. L’icône apparaît dans la barre d’outils.

- Pour Firefox ou Edge, suivez le même processus via leurs stores respectifs (addons.mozilla.org ou microsoftedge.microsoft.com).

Configuration (exemple : Web Scraper)

- Cliquez sur l’icône Web Scraper dans la barre d’outils.

- Créez un sitemap :

- Cliquez sur « Create new sitemap » > « Create sitemap ».

- Entrez un nom (ex. : « Amazon Prices ») et l’URL cible (ex. : https://amazon.com).

- Ajoutez des sélecteurs :

- Cliquez sur « Add new selector » et choisissez les éléments à extraire (ex. : prix, titres).

- Utilisez le mode point-and-click pour sélectionner visuellement les données.

- Lancez le scraping : Cliquez sur « Scrape » et exportez en CSV ou Excel.

Astuce : Consultez les vidéos tutorielles sur webscraper.io pour maîtriser les sitemaps complexes.

Comparaison : Web Scraping Local vs Cloud

Analyse et recommandations

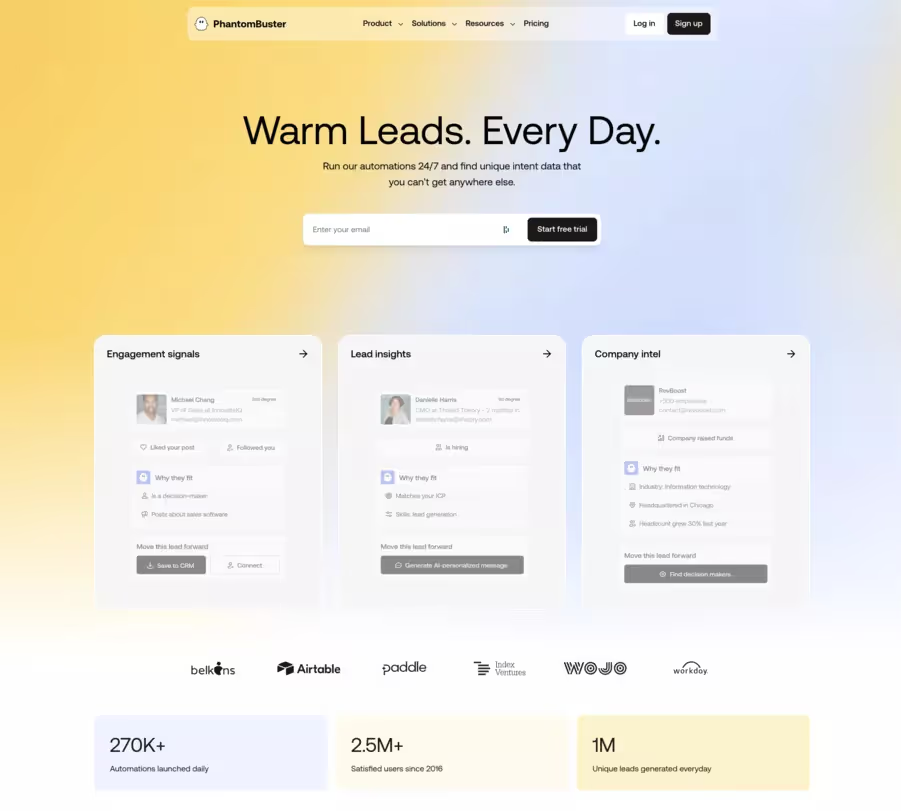

- Web Scraper Local : Parfait pour les débutants, marketeurs, ou analystes avec des besoins ponctuels et des budgets limités. Idéal pour extraire des données de petits sites (moins de 5000 pages) comme des listes Yelp ou des prix eBay. Cependant, il est limité par la puissance de votre machine et ne gère pas bien les restrictions anti-scraping.

- Web Scraper Cloud : Conçu pour les professionnels, agences, et entreprises gérant des scraping à grande échelle ou récurrents. Avec IP rotation, planification, et stockage cloud, il excelle pour des projets comme la surveillance des prix, le lead generation massif, ou l’analyse concurrentielle. Son coût est un frein pour les indépendants.

Précaution légale : Vérifiez les termes de service des sites scrapés et respectez le RGPD pour éviter des sanctions. Utilisez un VPN ou les proxies Cloud pour plus de sécurité.

Confidentialité et Sécurité lors du Web Scraping

Le web scraping, en tant que pratique de collecte et d’extraction de données à partir de sites web, soulève des enjeux majeurs en matière de confidentialité et de sécurité. Il est impératif pour les utilisateurs de respecter les conditions d’utilisation des sites web ciblés et de se conformer aux réglementations en vigueur, telles que le RGPD, afin d’éviter tout risque juridique lié à la collecte de données. L’extraction non autorisée de données personnelles ou la violation des droits de propriété intellectuelle peut entraîner des sanctions importantes.

Pour garantir une utilisation responsable du web scraping, il est recommandé d’opter pour des outils dotés de fonctionnalités de sécurité avancées, comme la configuration de délais entre les requêtes pour ne pas surcharger les serveurs des sites web. Les utilisateurs doivent également s’assurer de bien comprendre les politiques de confidentialité des sites qu’ils souhaitent scraper et de ne jamais collecter d’informations sensibles sans autorisation. Enfin, il est conseillé de privilégier des pratiques éthiques et transparentes lors de la collecte de données, afin de préserver la confiance et la sécurité de toutes les parties impliquées dans le processus de scraping.

Intégration avec d’Autres Outils

Le web scraping prend toute sa dimension lorsqu’il est intégré à d’autres outils et solutions, permettant ainsi d’optimiser l’exploitation des données collectées. Par exemple, les données extraites via une extension comme Web Scraper sur Chrome peuvent être importées dans des bases de données pour une analyse approfondie, ou encore utilisées pour alimenter des modèles de machine learning et automatiser la prise de décision.

Les utilisateurs peuvent facilement connecter leur extension de navigateur à des logiciels de bureau tels qu’Excel, ou à des plateformes en ligne pour visualiser et traiter les données en temps réel. L’intégration avec des outils de traitement de données, des scripts de programmation ou des solutions d’analyse permet d’automatiser des processus complexes et d’améliorer l’efficacité du travail. Par exemple, il est possible de créer des workflows où le scraping alimente directement des tableaux de bord, des rapports ou des systèmes de veille concurrentielle, offrant ainsi une expérience utilisateur enrichie et une valeur ajoutée à chaque étape du processus.

Analyse des Résultats de Scraping

Après l’extraction, l’analyse des résultats de scraping constitue une étape clé pour transformer les données brutes en informations exploitables. Les utilisateurs doivent d’abord nettoyer et structurer les données, en éliminant les doublons ou les erreurs, afin de garantir la qualité des informations recueillies. L’utilisation de logiciels d’analyse de données, comme les tableurs ou les outils statistiques, permet ensuite d’identifier des tendances, de détecter des modèles et de réaliser des calculs pertinents pour l’activité.

La visualisation des données, à travers des graphiques ou des tableaux de bord, facilite la compréhension et la communication des résultats auprès des équipes ou des décideurs. Il est essentiel d’interpréter ces analyses en fonction des objectifs initiaux du web scraping, qu’il s’agisse de veille concurrentielle, d’analyse de marché ou d’optimisation de la stratégie commerciale. En suivant ces étapes, les utilisateurs maximisent la valeur des données extraites et renforcent la pertinence de leurs actions basées sur le web scraping.

FAQ

Qu’est-ce que Web Scraper pour Chrome ?

Une extension gratuite pour extraire textes, prix, liens, ou images de sites web, exportables en CSV/XLSX. Idéal pour veille, leads, ou analyse évitant de faire du copier coller manuel pour se créer une base de données web mise à jour en temps réel.

Comment installer et lancer Web Scraper ?

Ajoutez l’extension via le Chrome Web Store. Ouvrez DevTools > Web Scraper, créez un sitemap, sélectionnez les données, et exportez en CSV sur votre bureau.

Quelles sont les limites de l’extension ?

Limitée pour les gros volumes (>100 000 pages) et sites avec anti-scraping. Solution : passez à Web Scraper Cloud (dès 50 $/mois) ou utilisez un proxy.

Comment faire du web scraping pour des sites web avec pagination ou sites web dynamiques ?

Configurez un sélecteur pour le bouton « Suivant » ou activez JavaScript execution pour les sites dynamiques. Testez sur une page avant d’étendre.

Quelles bonnes pratiques suivre ?

Respectez robots.txt, testez sur une page, utilisez des sélecteurs précis (CSS/XPath) pour éviter un travail de nettoyage ou formatage trop importants, et automatisez avec Web Scraper Cloud pour des scrapes réguliers.

.svg)